Introducción a Adversarial Machine Learning

Adversarial Machine Learning (AML) es una disciplina que se centra en el estudio de vulnerabilidades y fallos de seguridad en modelos de aprendizaje automático con el objetivo de hacerlos más seguros. Trata de comprender cómo se puede tratar de engañar y manipular la funcionalidad de estos modelos.

En los últimos años el machine learning en particular y la inteligencia artificial en general han tenido un enorme crecimiento y se están integrando en procesos de toma de decisiones críticas. Algunos ejemplos son los diagnósticos médicos o los futuros coches autónomos. Por eso es necesario tratar de minimizar la posibilidad de que esas decisiones puedan ser manipuladas por agentes maliciosos. Un ejemplo muy llamativo es el Optical Adversarial Attack (OPAD) en el que investigadores de la universidad de Purdue comprobaron que una señal de «stop» podía ser interpretada como una señal de límite de velocidad:

https://arxiv.org/pdf/2108.06247

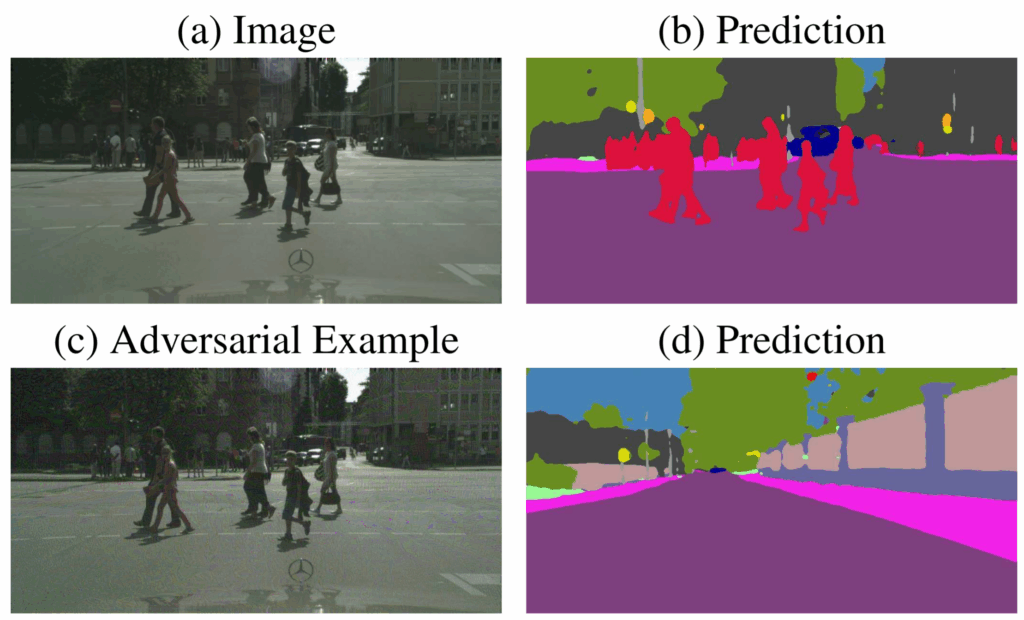

En 2017, investigadores como Jan Hendrik Metzen también mostraron cómo añadiendo ruido el modelo podría no detectar peatones y hacer pensar al coche que la carretera está libre de obstáculos:

Igualmente se han descrito otros ataques a modelos como los conocidos LLMs, que han permitido extraer información sensible u obtener respuestas que no estaban previstas. Tal es la preocupación por estos ataque que hasta OWASP publica un Top 10 para LLMs desde 2023 y lo ha actualizado este 2025:

https://owasp.org/www-project-top-10-for-large-language-model-applications

¿Qué hace que los modelos ML sean particularmente vulnerables?

- Dependen de los datos: Los modelos ML no existirían sin sus datos de entrenamiento, a partir de los que aprende. Si estos datos son incorrectos, sesgados o manipulados, las respuestas del modelo se verán afectadas.

- Son complejos y, a menudo, opacos: Muchos modelos ML son como «cajas negras» en los que es difícil saber cómo toman sus decisiones.

- Transferibilidad de los ataques: Permite que ataques desarrollados contra un modelo puedan ser efectivos contra otros modelos similares. https://llm-attacks.org/

- Falta de seguridad y robustez por diseño: La seguridad por diseño debería ser una máxima en cualquier sistema, incluidos los modelos ML, pero estos están optimizados para precisión en sus respuestas y no parar mitigar ataques, por lo que pequeñas perturbaciones en los datos de entrada pueden provocar grandes cambios en la salida.

En Red Team AI Labs vamos a estudiar, investigar y poner en práctica estos ataques en entornos controlados con el fin de desarrollar estrategias eficaces de defensa.

La siguiente no pretende ser una lista exhaustiva de ataques a modelos de machine learning, sino solo algunos ejemplos de los que iremos hablando en los siguientes posts:

- Ataques de evasión de modelos

- Ataques de extracción de modelos

- Inversión de modelos

- Envenenamiento de modelos

- Ataques específicos a LLMs

- Ataques a la infraestructura AI

Deja una respuesta